Одним из основных препятствий для широкого распространения машинного обучения в бизнесе является компромисс между интерпретируемостью и сложностью алгоритма. Чем сложнее внутренняя структура модели, тем более глубокие взаимосвязи между переменными она может находить, но и тем труднее она становится для понимания людьми, особенно не связанными напрямую с миром машинного обучения и статистики.

Самый банальный пример простой модели — линейная регрессия. Каждый коэффициент линейной регрессии показывает, как в среднем изменится предсказанное значение, если значение переменной вырастет на одну единицу.

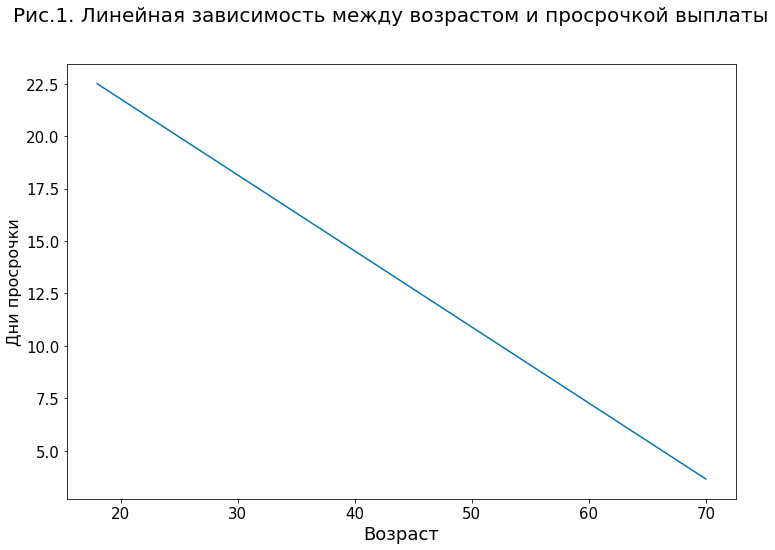

К примеру, рисунок 1 демонстрирует простейшую модель для предсказания количества дней просрочки выплаты кредитного займа с одной переменной — возрастом клиента. Согласно этой модели, увеличение возраста клиента на один год в среднем снижает прогноз по просрочке на 0,36 дней.

Однако, даже с линейными моделями не все так просто. Например, если в модели есть несколько сильно коррелированных переменных (например, возраст и количество закрытых кредитов в кредитной истории), прямая интерпретация коэффициентов при этих переменных может стать не такой уж банальной задачей. Еще сложнее дело обстоит с нелинейными моделями, где зависимости между переменными и предсказанием могут иметь сложную, немонотонную форму со множеством взаимозависимостей.

Такие модели в машинном обучении часто называют «черными ящиками» (black box). На вход модели подается набор переменных, на основе которых она рассчитывает свое предсказание, но то, как именно было принято это решение, какие факторы на него повлияли — ответы на эти вопросы зачастую остаются спрятаны в «черном ящике» алгоритма.

Прежде чем перейти к описанию существующих методов интерпретации, нелишним будет обсудить, что же именно понимается под интерпретируемостью модели и зачем вообще нужно интерпретировать и объяснять предсказания ML-моделей.

Что такое интерпретируемость?

Термин «интерпретируемость модели» является зонтичным, то есть он включает в себя целый набор признаков и определений.

В наиболее общем виде, интерпретируемость можно определить как степень того, насколько человек может понять причину, по которой было принято определенное решение (например, решение выдать кредит клиенту).

Это определение является хорошей стартовой точкой, но оно не дает ответа на многие важные вопросы. Например, кто именно имеется в виду под «человеком» — эксперт в данной предметной области или обычный человек «с улицы»? Какие факторы должны учитываться при оценке интерпретируемости — затраченные временные и умственные ресурсы, глубина понимания внутренних процессов моделей, доверие человека к ним?

Несмотря на отсутствие на текущий момент единого подхода к этому понятию, мы интуитивно чувствуем, что делает ML-модель более или менее интерпретируемой. Это любая информация в форме доступной для восприятия, которая улучшает наше понимание того, какие факторы и как именно повлияли на данное конкретное предсказание и на работу модели в целом. Эта информация может принимать разную форму, например, визуализации и графики или текстовые объяснения.

Полная версия статьи.